阿里发布了一款名为QWen2-VL-7B的视觉语言模型,该模型在OCR技术领域取得了显著成就,它能以100%的准确率识别英文手写体,在中文识别方面也表现夜很出色,达到了当前开源模型中的最佳水平。

该模型是开源的,这意味着大家都可以自由地使用和改进它。有助于在文字识别领域进一步研究和应用。想要在文字识别方面做出点成绩的朋友,不妨学习了解一下。

特色

高精度手写识别:英文手写体识别准确度达到100%,领先于同类开源模型。

出色的中文支持:在中文识别上也表现优异,能够处理复杂的中文字符。

视觉语言模型:结合了视觉和语言处理的能力,适用于多种图像识别和处理任务。

开源模型:作为开源模型,易于集成和使用,有助于推动社区的进一步研究和应用。

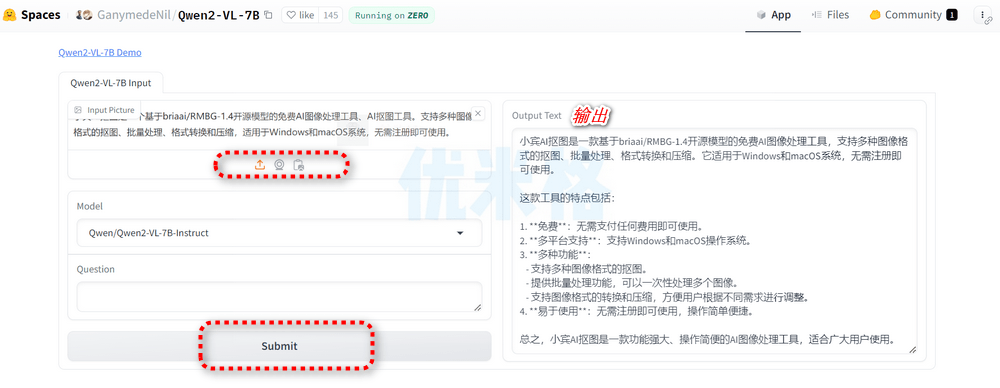

截图

网站地址

https://huggingface.co/spaces/GanymedeNil/Qwen2-VL-7B

参考

QWen2-VL-7B:阿里新发布视觉语言模型,OCR

能力达到同级开源模型 SOTA 效果

最新评论

需要登陆的吗?没有看到离线下载的?

谢谢

百度网盘的提取密码不对

哪个国家成功率高一点?换了十几个了